Introduzione alla MLOps

Introduzione alla MLOps

Introduzione alla MLOps: La Disciplina che Sta Rivoluzionando il Machine Learning in Produzione

Nel panorama tecnologico contemporaneo, le organizzazioni che investono in intelligenza artificiale e machine learning si trovano ad affrontare una sfida cruciale: come portare i modelli di machine learning dal laboratorio alla produzione in modo affidabile, scalabile e sostenibile nel tempo. È proprio per rispondere a questa esigenza che nasce la MLOps, una disciplina che sta rapidamente diventando essenziale per qualsiasi azienda che voglia sfruttare appieno il potenziale del machine learning.

Le Origini della MLOps: Quando la Necessità Diventa Innovazione – Introduzione alla MLOps

La MLOps affonda le sue radici in un momento storico preciso. Nel 2015, un gruppo di ricercatori di Google pubblicò un paper fondamentale intitolato “Hidden Technical Debt in Machine Learning Systems”, che evidenziava come i sistemi di machine learning accumulassero debito tecnico in modi complessi e spesso invisibili. Questo documento mise in luce una problematica critica: mentre i data scientist erano eccellenti nel creare modelli performanti in ambienti sperimentali, la transizione verso la produzione si rivelava sistematicamente problematica, costosa e inefficiente.

Cominciando l’Introduzione alla MLOps, il termine MLOps stesso nasce dalla combinazione di “Machine Learning” e “DevOps”, ereditando dalla metodologia DevOps i principi di automazione, collaborazione e continuous delivery, ma adattandoli alle specificità dei sistemi di machine learning. Da quel momento, la crescita della disciplina è stata esponenziale: il mercato delle soluzioni MLOps è stimato raggiungere i 4 miliardi di dollari entro il 2025, testimoniando la sua rapida adozione nelle organizzazioni di tutto il mondo.

Cos’è la MLOps: Una Definizione Autentica

La MLOps, o Machine Learning Operations, è definita come un insieme di pratiche, principi e strumenti che mira a sviluppare, distribuire e mantenere modelli di machine learning in produzione in modo affidabile, efficiente e scalabile. Andrew Ng, professore di Stanford University e imprenditore nel campo dell’intelligenza artificiale, la definisce come “una disciplina che comprende un insieme di principi, strumenti e best practice per creare e mantenere un progetto di machine learning nell’intero suo ciclo di vita”.

La MLOps non è semplicemente un’estensione del DevOps applicata al machine learning. È una disciplina a sé stante che riconosce la natura intrinsecamente sperimentale dei sistemi di ML e la maggiore complessità dei loro componenti rispetto ai sistemi software tradizionali. Mentre il DevOps si concentra sul codice e sulla sua distribuzione, la MLOps deve gestire anche dati, modelli, esperimenti, metriche di performance e drift dei dati nel tempo.

Perché la MLOps È Fondamentale: I Benefici Concreti

L’adozione della MLOps porta benefici tangibili e misurabili alle organizzazioni. In primo luogo, riduce drasticamente il time-to-market dei modelli di machine learning. Senza MLOps, il passaggio dalla fase di sviluppo a quella produttiva può richiedere mesi; con processi MLOps ben strutturati, questo tempo si riduce a settimane o addirittura giorni.

La MLOps migliora significativamente la riproducibilità degli esperimenti. Tracciando sistematicamente dataset, hyperparametri, configurazioni e risultati, i team possono ricostruire esattamente qualsiasi esperimento passato, facilitando il debugging e l’ottimizzazione incrementale dei modelli. Questo aspetto è particolarmente critico in settori regolamentati come healthcare e finance, dove la tracciabilità delle decisioni algoritmiche è un requisito normativo.

Un altro beneficio cruciale è la gestione del model drift. I modelli di machine learning non sono statici: le loro performance degradano nel tempo a causa dei cambiamenti nei dati sottostanti. La MLOps implementa sistemi di monitoraggio continuo che rilevano automaticamente quando un modello inizia a perdere accuratezza, permettendo interventi tempestivi prima che l’impatto sul business diventi significativo.

La MLOps favorisce inoltre la collaborazione tra data scientist, ML engineers e team operations, abbattendo i silos organizzativi che tipicamente rallentano i progetti di AI. Standardizzando processi e strumenti, facilita la scalabilità orizzontale dei team e riduce la dipendenza da singole figure chiave.

MLOps, LLM e AI Generativa: Un’Evoluzione Necessaria

L’esplosione dei Large Language Models e dell’AI generativa ha portato nuove sfide che richiedono un’evoluzione della MLOps tradizionale. I LLM, con i loro miliardi di parametri e i requisiti computazionali massicci, introducono complessità senza precedenti nella gestione del ciclo di vita dei modelli.

È in questo contesto che emergono nuove specializzazioni come la LLMOps (Large Language Model Operations) e la GenAIOps (Generative AI Operations). Queste estensioni della MLOps affrontano sfide specifiche dell’AI generativa: il prompt engineering diventa un componente critico da versionare e ottimizzare; il monitoraggio deve includere metriche qualitative come la coerenza e l’appropriatezza delle risposte generate; la gestione dei costi computazionali diventa centrale dato l’elevato costo dell’inferenza sui LLM.

Le organizzazioni con investimenti consolidati in MLOps sono in una posizione privilegiata per adottare l’AI generativa. I principi fondamentali rimangono validi: versioning, continuous integration/continuous deployment, monitoring e governance. Tuttavia, è necessario integrare nuovi pattern tecnici specifici per i foundation models, come la gestione dei vector database per il retrieval-augmented generation (RAG), il fine-tuning efficiente e il tracking delle interazioni prompt-risposta.

Problematiche Risolte dalla MLOps: Scenari Reali

Consideriamo uno scenario concreto nel settore e-commerce. Un’azienda sviluppa un sistema di raccomandazione prodotti che funziona brillantemente in fase di test. Tuttavia, quando viene distribuito in produzione, emergono problematiche: il modello non si aggiorna con i nuovi prodotti del catalogo, le performance variano significativamente tra diverse categorie merceologiche, e non esiste un sistema per rollback rapido in caso di problemi. La MLOps risolve questi problemi implementando pipeline automatizzate per il re-training periodico, A/B testing per validare nuove versioni del modello, e deployment canary per rilasci progressivi e sicuri.

Nel settore finanziario, un caso tipico riguarda i modelli di fraud detection. Senza MLOps, quando i pattern di frode evolvono (come accade continuamente), il modello diventa rapidamente obsoleto ma nessuno se ne accorge finché non è troppo tardi. La MLOps implementa sistemi di alerting che rilevano anomalie nelle distribuzioni dei dati e nei pattern predittivi, permettendo interventi proattivi.

Nel healthcare, dove un modello di diagnosi assistita deve garantire affidabilità e compliance normativa, la MLOps fornisce audit trail completi di ogni decisione del modello, tracciabilità dei dataset di training, e processi di validazione rigorosi che documentano le performance su diverse popolazioni di pazienti.

Come Applicare la MLOps nei Propri Progetti: Consigli Pratici – Introduzione alla MLOps

L’implementazione della MLOps richiede un approccio incrementale e pragmatico. Il primo passo è iniziare con il versioning: prima ancora di pensare a deployment automatizzati, assicuratevi che codice, dati e modelli siano versionati in modo rigoroso. Utilizzate Git per il codice, DVC (Data Version Control) per i dataset, e un model registry per tracciare le versioni dei modelli.

Il secondo step è automatizzare il training. Create pipeline riproducibili che trasformino dati raw in modelli deployati, documentando ogni passaggio. Iniziate con pipeline semplici e aumentate gradualmente la complessità.

Il terzo elemento critico è il monitoring. Implementate dashboard che traccino non solo metriche tecniche (latenza, throughput) ma anche metriche di business e data quality metrics. Il monitoring deve essere proattivo, non reattivo.

Infine, adottate una mentalità di continuous improvement. La MLOps non è un progetto con un inizio e una fine, è un processo continuo di raffinamento e ottimizzazione.

Integrare la MLOps nel Team IT Aziendale

L’introduzione della MLOps in un’organizzazione richiede non solo tecnologia ma anche change management. È fondamentale formare un team cross-funzionale che includa data scientist, ML engineers, DevOps engineers e rappresentanti del business.

Iniziate con un progetto pilota su un caso d’uso a basso rischio ma con chiaro valore di business. Questo permette al team di acquisire familiarità con gli strumenti e i processi MLOps senza la pressione di sistemi mission-critical.

Create una cultura della documentazione e della condivisione della conoscenza. La MLOps introduce molti nuovi concetti e strumenti; è essenziale che il know-how non rimanga confinato a poche persone.

Definite metriche di successo chiare fin dall’inizio. Quanto tempo ci vuole per portare un modello in produzione? Quanti modelli sono attualmente monitorati? Qual è il tasso di rollback? Queste metriche guidano il miglioramento continuo.

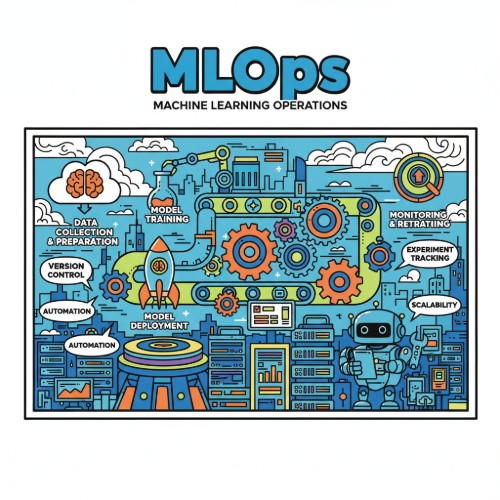

I Componenti Fondamentali della MLOps

Un’architettura MLOps completa si compone di diversi componenti interconnessi. Il Data Pipeline gestisce l’ingestion, la trasformazione e la validazione dei dati, assicurando che i modelli ricevano input di qualità consistente.

Il Feature Store centralizza la gestione delle feature, garantendo consistenza tra training e serving e riducendo la duplicazione del codice di feature engineering.

L’Experiment Tracking registra tutti gli esperimenti di training, includendo hyperparametri, metriche, dataset utilizzati e artefatti generati, permettendo di confrontare diverse versioni e riprodurre risultati passati.

Il Model Registry funziona come repository centralizzato per i modelli, tracciando versioni, metadata, performance e stato (staging, production, archived).

Il Model Serving gestisce il deployment dei modelli e l’inferenza, con funzionalità come load balancing, autoscaling e A/B testing.

Il Monitoring & Observability traccia continuamente le performance dei modelli in produzione, rilevando data drift, concept drift e anomalie.

Infine, il CI/CD per ML automatizza testing, validazione e deployment dei modelli, estendendo le pratiche DevOps al ciclo di vita del machine learning.

Strumenti e Piattaforme MLOps: Open Source ed Enterprise – Introduzione alla MLOps

Il panorama degli strumenti MLOps è ricco e diversificato. Tra le soluzioni open source, MLflow di Databricks è probabilmente la più popolare per la sua semplicità e modularità. È ideale per team piccoli e medi che vogliono iniziare con MLOps senza complessità eccessive. I suoi componenti principali includono tracking degli esperimenti, model registry e deployment capabilities.

Kubeflow rappresenta l’approccio cloud-native alla MLOps. Progettato per Kubernetes, offre un framework completo per orchestrare workflow di ML complessi. È la scelta ideale per organizzazioni che hanno già investito nell’ecosistema Kubernetes e necessitano di scalabilità e portabilità multi-cloud.

DVC (Data Version Control) risolve specificamente il problema del versioning dei dati e delle pipeline, integrandosi perfettamente con Git e fornendo funzionalità simili a Git ma ottimizzate per file di grandi dimensioni.

Tra le piattaforme enterprise, AWS SageMaker offre un ecosistema integrato che copre l’intero ciclo di vita del ML, con particolare forza nell’integrazione con gli altri servizi AWS. Azure Machine Learning fornisce capabilities simili nell’ecosistema Microsoft, con eccellente supporto per ambienti hybrid cloud.

Google Vertex AI rappresenta la proposta di Google Cloud, unificando diversi servizi precedentemente separati in una piattaforma coesa con forte focus su AutoML e AI generativa.

Databricks, pur essendo principalmente una piattaforma di data analytics, ha costruito capacità MLOps robuste attorno a MLflow, offrendo un’esperienza integrata per team che lavorano intensivamente con Spark.

Piattaforme emergenti come TrueFoundry stanno guadagnando trazione offrendo soluzioni modulari e cloud-agnostic che supportano sia MLOps tradizionale che LLMOps, con particolare attenzione alla flessibilità e al controllo sull’infrastruttura.

MLOps vs DevOps: Differenze e Complementarità – Introduzione alla MLOps

Sebbene MLOps erediti molti principi dal DevOps, esistono differenze fondamentali che giustificano una disciplina separata. Il DevOps si concentra principalmente sul codice, mentre la MLOps deve gestire la triade codice-dati-modelli. Nel DevOps, il codice è deterministico: lo stesso input produce sempre lo stesso output. Nel ML, i modelli sono probabilistici e le loro performance dipendono criticamente dai dati di training.

Il testing nel DevOps è relativamente straightforward: si verificano comportamenti attesi con unit test e integration test. Nel ML, il testing è più sfumato: si devono validare performance statistiche, fairness, robustness e comportamento su edge cases. Non esiste un semplice “pass/fail”.

Il monitoring nel DevOps traccia principalmente metriche di sistema (CPU, memoria, latenza). Nel ML, si devono monitorare anche data drift, concept drift, feature distributions e metriche di business specifiche del modello.

Il deployment nel DevOps è tipicamente un evento discreto: si rilascia una nuova versione. Nel ML, i modelli richiedono re-training continuo e il deployment è un processo ongoing. Inoltre, strategie come shadow deployment e champion/challenger sono molto più comuni nel ML.

Nonostante queste differenze, MLOps e DevOps sono complementari. Le organizzazioni che hanno cultura DevOps matura trovano più facile adottare MLOps perché i principi fondamentali (automazione, versioning, continuous integration) sono già parte del DNA aziendale.

L’Importanza Critica della Formazione del Personale IT

Nel contesto dell’evoluzione rapidissima delle tecnologie di AI e ML, la formazione continua del personale IT non è più un optional, è una necessità strategica. La MLOps introduce paradigmi, strumenti e best practices che possono risultare completamente nuovi anche per professionisti esperti. Senza formazione adeguata, i team rischiano di commettere errori costosi: modelli che falliscono silenziosamente in produzione, data leak tra training e test set, bias non rilevati, o semplicemente inefficienze che moltiplicano i costi operativi.

La formazione strutturata accelera drasticamente l’adozione di nuove pratiche, riducendo il time-to-competency da mesi a settimane. Inoltre, crea un linguaggio comune all’interno dell’organizzazione, facilitando la collaborazione tra ruoli diversi. Un data scientist che comprende le sfide del deployment e un DevOps engineer che comprende le peculiarità del ML lavorano insieme molto più efficacemente.

Corso Generative AI Engineering e MLOps: La Soluzione per le Aziende

Per le aziende che vogliono equipaggiare i propri team con competenze all’avanguardia in MLOps e AI Generativa, Innovaformazione offre il Corso Generative AI Engineering e MLOps , specificamente progettato per aziende ed per i loro team di sviluppatori software e consulenti di AI/ML.

Il corso copre in modo completo sia i fondamenti della MLOps che le più recenti evoluzioni nel campo dell’AI generativa e dei Large Language Models. I partecipanti acquisiscono competenze pratiche e immediatamente applicabili sui principali tool e piattaforme MLOps, apprendono pattern architetturali per integrare LLM nelle applicazioni aziendali, e sviluppano la capacità di progettare e implementare pipeline ML-to-production robuste e scalabili.

Il format è online in classe virtuale con calendario flessibile da concordare in base alle esigenze aziendali, permettendo di organizzare la formazione senza impattare significativamente sulle attività operative. Un vantaggio fondamentale per le aziende è la possibilità di ottenere la formazione completamente finanziata (quindi gratis) tramite Fondimpresa o altri fondi interprofessionali a cui l’azienda è aderente, rendendo l’investimento in formazione a costo zero per l’organizzazione.

Investire nella formazione del proprio team IT significa investire nella capacità dell’azienda di innovare velocemente, ridurre gli errori, e rimanere competitivi in un mercato dove l’AI sta diventando un differenziatore strategico fondamentale.

Conclusioni – Introduzione alla MLOps

La MLOps rappresenta un’evoluzione necessaria per qualsiasi organizzazione che voglia portare il machine learning oltre la fase sperimentale e generare valore di business reale e sostenibile. Non è semplicemente una moda tecnologica, ma una risposta pragmatica a sfide concrete che emergono sistematicamente quando si cerca di industrializzare sistemi di intelligenza artificiale.

L’adozione della MLOps richiede investimenti in tecnologia, processi e soprattutto persone. La formazione del personale IT è l’elemento che fa la differenza tra un’implementazione MLOps efficace e un insieme di strumenti sottoutilizzati. In un campo che evolve rapidamente come l’AI e il machine learning, la capacità di apprendimento continuo del team diventa il vero vantaggio competitivo sostenibile.

Le organizzazioni che investono oggi in MLOps e nella formazione dei propri team si posizionano per dominare il panorama competitivo di domani, dove l’AI non sarà più un esperimento ma il cuore pulsante delle operazioni di business.

(fonte) (fonte) (fonte) (fonte)

Innovaformazione, scuola informatica specialistica promuove le tematiche dell’AI e del MLOps applicato in modo consapevole. Per visionare l’offerta formativa per aziende nel tema AI Generativa invitiamo a navigare sul nostro sito a questo LINK.

INFO e preventivi: info@innovaformazione.net – TEL. 3471012275 (Dario Carrassi)

Vuoi essere ricontattato? Lasciaci il tuo numero telefonico e la tua email, ti richiameremo nelle 24h:

Articoli correlati

Come sviluppare una applicazione enterprise opensource

SAP ABAP e programmazione funzionale

Introduzione ad OpenEuro LLM

Lavoro Contabilità Generale Milano

Novità PHP 8.4