DNA Language Models

DNA Language Models: Futuro AI

Introduzione: Quando l’AI Impara il Linguaggio della Vita

Dieci anni fa, DeepMind ha rivoluzionato il campo dell’intelligenza artificiale dimostrando che una singola architettura neurale poteva imparare a giocare decine di videogiochi Atari diversi, superando le prestazioni umane. Oggi, quella stessa filosofia sta per decodificare il codice della vita stessa attraverso i DNA Language Models (GenLM). Se non state già esplorando questa frontiera, rischiate seriamente di diventare obsoleti nel panorama IT contemporaneo.

Questi scenari vengono descritti da una interessante conferenza di Mikhail Burtsev della London Institute for Mathematical Sciences . Mikhail Burtsev in questo tour delle applicazioni biologiche all’avanguardia dell’intelligenza artificiale, inclusa la sua, spiega come l’AI sta rendendo complesse conoscenze biologiche più accessibili che mai. Chatbot di intelligenza artificiale come ChatGPT sono addestrati sul linguaggio umano, ma questi nuovi modelli di intelligenza artificiale vengono invece alimentati con miliardi di sequenze di DNA reale, consentendo loro di compiere imprese sorprendenti come la progettazione di nuove molecole biologiche o persino di interi nuovi genomi batterici. Il loro obiettivo finale è risolvere forse il problema più fondamentale di tutta la biologia: leggere e comprendere il progetto genetico della vita dall’inizio alla fine.

Mikhail Burtsev è Landau AI Fellow presso il London Institute for Mathematical Sciences. Ha studiato microelettronica presso l’Istituto di Ingegneria Elettrica di Mosca, prima di conseguire il dottorato di ricerca in informatica presso l’Istituto di Matematica Applicata Keldysh. È stato Direttore Scientifico dell’Istituto di Ricerca sull’Intelligenza Artificiale di Mosca e ha fondato e gestito il Laboratorio di Reti Neurali e Deep Learning presso l’Istituto di Fisica e Tecnologia di Mosca. Sotto la sua guida, ha sviluppato il pluripremiato framework open source di intelligenza artificiale conversazionale DeepPavlov. La sua ricerca si concentra sulla matematica alla base di un’intelligenza artificiale più intelligente, tra cui reti neurali con apprendimento continuo e memoria aumentata, nonché matematica assistita dall’intelligenza artificiale.

Dalla Biologia Molecolare all’Architettura Neurale – DNA Language Models

La biologia è storicamente la scienza naturale con la minore formalizzazione matematica. Perché? Il nostro corpo umano comprende 11 sistemi organici, 78 organi, circa 30 trilioni di cellule di oltre 100 tipi diversi, ciascuna contenente più di 40 milioni di proteine appartenenti a oltre 10.000 tipologie differenti. Questa complessità gerarchica, dove ogni livello interagisce con gli altri, sembrava resistere a qualsiasi tentativo di modellizzazione sistematica.

Tuttavia, l’intero sistema è codificato in circa 3 miliardi di nucleotidi del genoma umano. Ed è qui che i DNA language models entrano in gioco con una promessa rivoluzionaria: applicare gli stessi principi del natural language processing (NLP) per decifrare il linguaggio genomico.

Il Paradigma Transfer Learning applicato al DNA

L’approccio fondamentale dei GenLM si basa sul transfer learning, che prevede due fasi distinte:

- Pre-training: Il modello viene addestrato sull’intero genoma per predire il nucleotide successivo in una sequenza, esattamente come GPT predice la parola successiva. Nessuna conoscenza biologica viene esplicitamente inserita: il modello impara autonomamente i pattern.

- Fine-tuning: Il modello pre-addestrato viene specializzato su task specifici come la predizione di promotori genici, l’identificazione di siti di legame per fattori di trascrizione, o la valutazione del rischio di malattie.

Ecco un esempio concettuale in Python di come potrebbe essere strutturato un semplice DNA language model:

import torch

import torch.nn as nn

class SimpleDNALanguageModel(nn.Module):

def __init__(self, vocab_size=4, embedding_dim=128, hidden_dim=256):

super().__init__()

# vocab_size=4 per A, C, G, T

self.embedding = nn.Embedding(vocab_size, embedding_dim)

self.transformer = nn.TransformerEncoder(

nn.TransformerEncoderLayer(d_model=embedding_dim, nhead=8),

num_layers=6

)

self.fc = nn.Linear(embedding_dim, vocab_size)

def forward(self, x):

# x shape: (batch_size, sequence_length)

embedded = self.embedding(x) # (batch, seq_len, embed_dim)

transformed = self.transformer(embedded)

output = self.fc(transformed) # (batch, seq_len, vocab_size)

return output

# Tokenizzazione DNA

nucleotide_to_idx = {'A': 0, 'C': 1, 'G': 2, 'T': 3}

def tokenize_dna(sequence):

return torch.tensor([nucleotide_to_idx[n] for n in sequence])

# Training loop per predizione next-nucleotide

model = SimpleDNALanguageModel()

sequence = "ATCGATCGATCG"

tokens = tokenize_dna(sequence[:-1]) # Input

target = tokenize_dna(sequence[1:]) # Target shifted

Neural Scaling Laws e il Vantaggio dei Dati Genomici

Un aspetto critico emerso dalla conferenza di Mikhail Burtsev riguarda le neural scaling laws: più dati, più parametri e più compute portano a risultati migliori. Il problema? I large language models testuali hanno già saturato quasi tutto il contenuto testuale disponibile online.

Ma i dati genomici seguono una traiettoria completamente diversa. Attualmente, la quantità di sequenze DNA pubblicamente disponibili è paragonabile ai dati testuali utilizzati per addestrare GPT. Tuttavia, grazie al sequenziamento genomico sempre più economico, ogni 18 mesi i dati genomici raddoppiano. Entro 2-3 anni avremo cinque volte più dati genomici che dati testuali.

Questo rappresenta un vantaggio competitivo straordinario per chi si posiziona ora in questo settore.

Svolta Tecnologica: Da AlphaFold ai Memory Transformers

AlphaFold: Rivoluzione nella Predizione Strutturale

AlphaFold di DeepMind ha dimostrato che è possibile predire strutture proteiche 3D da sequenze aminoacidiche con accuratezza comparabile agli esperimenti di cristallografia a raggi X, processo che tradizionalmente richiedeva mesi e centinaia di migliaia di sterline. Nel 2024, AlphaFold 3 ha esteso queste capacità predicendo anche interazioni tra proteine, DNA, RNA, piccole molecole e ioni. Il database AlphaFold conta ora oltre 214 milioni di strutture predette, democratizzando l’accesso a informazioni strutturali essenziali per la biologia molecolare.

Memory-Augmented Transformers: Superare il Limite del Contesto

Un problema fondamentale dei DNA language models è la lunghezza del contesto. Il genoma umano contiene 3 miliardi di base pairs, ma i transformer tradizionali possono elaborare solo sequenze limitate (tipicamente migliaia di token).

La soluzione proposta sono i Recurrent Memory Transformers e gli Associative Recurrent Memory Transformers, architetture capaci di processare sequenze ultra-lunghe mantenendo memoria dei contesti precedenti. Questi modelli hanno stabilito record mondiali, elaborando fino a 50 milioni di parole nel benchmark “needle in a haystack”.

Ecco una visualizzazione concettuale del meccanismo di memoria:

class MemoryAugmentedTransformer(nn.Module):

def __init__(self, model_dim=512, memory_size=1024):

super().__init__()

self.transformer_block = nn.TransformerEncoder(...)

self.memory = nn.Parameter(torch.zeros(memory_size, model_dim))

self.memory_gate = nn.Linear(model_dim, 1)

def forward(self, x, prev_memory=None):

# Processa segmento corrente

hidden = self.transformer_block(x)

# Integra memoria precedente

if prev_memory is not None:

combined = torch.cat([hidden, prev_memory], dim=0)

hidden = self.transformer_block(combined)

# Aggiorna memoria per il prossimo segmento

gate = torch.sigmoid(self.memory_gate(hidden))

new_memory = gate * hidden + (1 - gate) * prev_memory

return hidden, new_memory

Questo approccio permette di accumulare informazioni rilevanti lungo sequenze genomiche estremamente lunghe, cruciali per catturare le interazioni a lungo raggio tra geni distanti nel genoma.

Applicazioni Rivoluzionarie: Dall’Organo alla Molecola – DNA Language Models

Livello Organico: Predizione di Malattie da Elettrocardiogrammi

Ricercatori dell’Imperial College London hanno addestrato reti neurali su 1 milione di tracciati ECG, riuscendo a predire con il 70% di accuratezza il rischio di sviluppare diabete di tipo 2 anni prima che i sintomi si manifestino, analizzando solo l’attività cardiaca. Questo dimostra che l’AI può identificare connessioni sistemiche tra apparati organici apparentemente disconnessi, aprendo scenari di medicina predittiva preventiva.

Livello Molecolare: Feature Attribution e Scoperta di Motivi Regolativi

Una volta addestrati i DNA language models, è possibile applicare tecniche di feature attribution per identificare quali nucleotidi specifici influenzano maggiormente le predizioni. Nel paper pubblicato su Nucleic Acids Research (gennaio 2025), il modello GENA-LM è stato fine-tunato per predire siti di legame del fattore di trascrizione CTCF, e l’analisi ha rivelato motivi genomici coerenti con studi sperimentali indipendenti.

Questo approccio crea un terreno comune per connettere processi biologici a diversi livelli di organizzazione: cellulare, tissutale, organico e sistemico.

Scenari Futuri: Verso la Biologia Generativa

L’orizzonte più ambizioso dei DNA language models è la biologia generativa: la capacità non solo di analizzare, ma di progettare sequenze genomiche ex novo. Immaginate di chiedere a un’AI: “Genera il genoma di un leone delle dimensioni di un gatto domestico”, e 90 giorni dopo ricevere un organismo vivente da un laboratorio di sintesi genomica.

Questo scenario, per quanto fantascientifico possa sembrare, si basa su fondamenta tecnologiche solide:

- Modelli fondazionali addestrati su genomi multi-specie catturano principi universali della vita

- Transfer learning permette specializzazione su task specifici con dati limitati

- Feature attribution rivela i meccanismi causali sottostanti le predizioni

- Sintesi genomica è già una realtà nei laboratori avanzati

Modelli come Evo (Stanford, 2024) e GROVER (Nature Machine Intelligence, 2024) stanno già dimostrando capacità generative preliminari, scrivendo sequenze genetiche funzionali de novo.

L’Imperativo dell’Aggiornamento Professionale – DNA Language Models

Nel 2025, l’intelligenza artificiale non è più un’opzione ma un requisito di sopravvivenza professionale. I professionisti IT che non padroneggeranno l’AI generativa, i DNA language models e le architetture transformer avanzate saranno inevitabilmente superati da colleghi più preparati e da strumenti automatizzati sempre più sofisticati.

La convergenza tra bioinformatica e AI sta creando un mercato del lavoro in rapida trasformazione, dove le competenze tradizionali di programmazione non bastano più. È necessario comprendere:

- Architetture neurali moderne (Transformers, Diffusion Models)

- Principi di transfer learning e fine-tuning

- Gestione di dati genomici e pipeline bioinformatiche

- Implementazione pratica con framework come PyTorch, TensorFlow, Hugging Face

Formazione Continua: L’Unica Strategia Vincente – DNA Language Models

Per rimanere competitivi, è essenziale investire in formazione continua strutturata. I Corsi AI Generativa di Innovaformazione.net offrono percorsi formativi mirati per team aziendali, con:

- Modalità classe virtuale online per massima flessibilità

- Calendario personalizzato adattabile alle esigenze aziendali

- Corsi su richiesta e ad hoc per competenze specifiche

- Programmi aggiornati alle ultime innovazioni del settore

Non aspettate che la competizione vi superi. L’AI sta riscrivendo le regole del gioco in ogni settore IT, dalla sanità alla finanza, dall’agricoltura all’energia. Chi si forma oggi, guiderà l’innovazione domani. Chi rimanda, rischia l’irrilevanza professionale.

Conclusioni – DNA Language Models: La Roadmap verso il Futuro della Biologia

La roadmap tracciata da Mikhail Burtsev e dalla comunità scientifica è chiara:

- Oggi: I DNA language models imparano il codice genetico della vita attraverso modelli fondazionali addestrati su scala genomica

- Domani: Questi modelli predirranno e interpreteranno fenomeni molecolari, cellulari e organici direttamente dalle sequenze genomiche

- Dopodomani: Man mano che più genomi verranno sequenziati, decifreremo processi biologici in tutti gli organismi conosciuti

Questo percorso risponderà alle domande più profonde della biologia e trasformerà radicalmente la medicina umana. Ma accadrà solo se i professionisti IT di oggi investiranno nelle competenze di domani.

L’intelligenza artificiale è il linguaggio del futuro. Imparatelo ora, o diventate obsoleti.

(fonte) (fonte) (fonte) (fonte) (fonte)

Per altri articoli tecnici consigliamo di navigare sul nostro blog QUI.

Innovaformazione, scuola informatica specialistica promuove la cultura dell’Intelligenza Artificiale e divulga articoli tecnici. Affianchiamo le aziende nella formazione del team IT, trovate il catalogo corsi completo sul nostro sito QUI.

INFO: info@innovaformazione.net – TEL. 3471012275 (Dario Carrassi)

Vuoi essere ricontattato? Lasciaci il tuo numero telefonico e la tua email, ti richiameremo nelle 24h:

Articoli correlati

Cosa è Laminas

Strumenti AI per sistemisti

Integrare l’AI nei propri software

Body Rental SAP

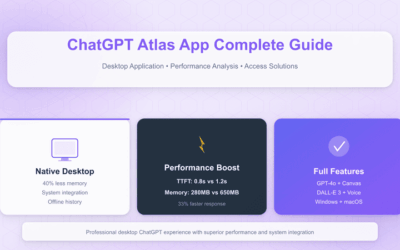

Cosa è ChatGPT Atlas