Cosa sono Small Language Models

Cosa sono gli SLM (Small Language Models)

Origini e nascita

Negli ultimi anni, con la diffusione esplosiva dei Large Language Models (LLM) come GPT-3/4, PaLM, LLaMA, Claude, ecc., si è evidenziato che non sempre serve un modello enorme per certe applicazioni. I Small Language Models (SLM) nascono proprio per quei casi in cui:

- il costo computazionale è vincolante (hardware limitato, edge device, mobile, IoT);

- la latenza è critica;

- il dominio è ristretto / specializzato;

- la privacy richiede che i dati non escano da un ambiente controllato;

- si vuole un modello più facilmente customizzabile (fine-tuning, distillazione, quantizzazione).

In pratica, la nascita dello SLM è una risposta al trade-off tra capacità generali e risorse (tempo, costo, hardware, dati, energia). È emergente come categoria da circa 2023-2024, quando molte aziende e gruppi di ricerca hanno iniziato a rilasciare modelli con decine di miliardi, oppure anche meno, di parametri che competono abbastanza bene per compiti specifici.

Definizione tecnica – Cosa sono Small Language Models

Un Small Language Model (SLM) è un modello di linguaggio basato sull’architettura transformer (o affine), con un numero significativamente inferiore di parametri rispetto ai modelli di scala “gigante” (LLM), tipicamente da qualche centinaio di milioni fino a decine di miliardi di parametri, ottimizzato per efficienza, latenza, risorse hardware, o esecuzione su dispositivi locali o edge.

Le caratteristiche tecniche che definiscono uno SLM includono:

- Numero di parametri ridotto (es. < ~50B, spesso tra 0.5B e 15B) rispetto a LLMs che possono avere centinaia di miliardi fino a oltre 1000B.

- Architettura base simile (transformer decoder-only, encoder-decoder, o varianti), ma con meno layer, meno unità per layer, oppure tecniche di pruning, quantizzazione, distillazione per ridurre peso e requisiti.

- Ottimizzazione per particolari use-case: ad esempio, lingua specifica, dominio specifico, generazione testuale limitata, ragionamento semplice, inferenza locale.

- Prestazioni decenti (accuratezza, coerenza) in compiti ben definiti, ma tendenzialmente inferiori a LLM su compiti generali o emergenti che richiedono comprensione estensiva e contesto lungo.

Architettura e funzionamento – Cosa sono Small Language Models

Lo SLM usa generalmente le stesse strutture base degli LLM:

- Trasformer (self-attention, heads, embeddings).

- Tokenizzazione (subword, BPE, byte-pair, WordPiece, o varianti multilingue).

- Pre-training su grandi corpora (anche se non vastissimi come per gli LLM), spesso generalisti + dati specializzati.

- Tecniche di compressione:

- Knowledge distillation: un modello “studente” impara da un modello “teacher” che può essere un LLM, trasferendo tanto comportamento quanto possibile pur con meno parametri.

- Pruning: rimozione di pesi/neuron nodes ritenuti meno utili.

- Quantizzazione: ridurre la precisione numerica per accelerare e alleggerire la memoria.

- Altre varianti: architetture sparse, mixture-of-experts (MoE) limitate, riduzione del contesto (context window) se possibile.

- Fine-tuning e addestramento specifico: per domini ristretti, per comportamenti particolari (es. generazione, traduzione, classification).

Confronto tecnico: SLM vs LLM

| Parametro | SLM (Small Language Model) | LLM (Large Language Model) |

|---|---|---|

| Numero di parametri | tipicamente 0.5B – ~15-50B; spesso anche < 10B in molte varianti. | decine a centinaia di miliardi, fino a >1000B (o più) parametri. |

| Hardware / risorse | può essere eseguito su GPU consumer, su dispositivi mobili, edge, su cloud leggero. Risorse di memoria, compute più contenute. | richiede GPU ad alte prestazioni, cluster, grande memoria, potenza di calcolo, costi elevati. |

| Latenza / throughput | inferenza più veloce, latenza inferiore, throughput elevato per richiesta. | inferenza più lenta, tempi maggiori, più overhead per gestire grandi modelli. |

| Flessibilità / generalità | migliore in domini specifici; meno robusto su compiti non visti; generale ma con limiti; può venire “specializzato”. | ampia generalità, emergenti capacità, molti task diversi, migliori performance in zero-shot/few-shot. |

| Costo di sviluppo e operazione | costi inferiori: per training, fine-tuning, deploy, manutenzione. Meno energia. | costi elevatissimi, sia hardware che energetici; consumi non trascurabili. |

| Privacy / sicurezza | più facile da eseguire in locale, riduce rischi dati, controlli più diretti; possibilità di isolare il sistema. | spesso basato su cloud; difficoltà maggiori nel garantire che dati sensibili non fuoriescano; controlli più complessi. |

| Uso su dispositivo edge / mobilità | adatto: smartphone, IoT, off-line, con memoria limitata; batteria come vincolo. | raramente; solo versioni molto ottimizzate; generalmente cloud or server. |

| Capacità emergenti / ragionamento complesso | limitate capacità emergenti; più difficoltà in ragionamenti multi-step, contesti lunghi, ambiguità elevata. | migliori capacità emergenti, contesti lunghi, ragionamento complesso, capacità di few/zero-shot. |

| Scalabilità | scalabile su scala piccola-media; più semplice incrementare dimensione o specializzazione. | scalabile verso modelli enormi; più complesso gestire distribuzione, parallelismo, limiti di memoria. |

| Energia / impatto ambientale | inferiore impatto energetico, minor uso di risorse, più “green”. | elevato consumo energetico, maggior impatto ambientale, costi di raffreddamento, infrastrutture varie. |

| Controllo e personalizzazione | più facile da personalizzare, fine-tuning, controllo dei dati di addestramento; più trasparente in molti casi. | difficoltà maggiore nel personalizzare in modo specifico; rischi legati a bias, generalizzazione incontrollata. |

| Costo economico / deployment | basso costo per molte aziende, aziende piccole e medie; deployment più semplice. | costi elevati, spesso solo grandi aziende o servizi cloud possono permetterselo pienamente. |

Quando usare gli SLM: pro e contro

Pro

- Efficienza: risparmi in termini di GPU/CPU, memoria, latenza. Utile specialmente per applicazioni real-time o dispositivi con risorse limitate.

- Costi ridotti: meno infrastruttura, minori bollette energetiche, costi di manutenzione inferiori.

- Privacy e controllo: se il modello è locale o on-premises, si ha pieno controllo sui dati; importante in settori regolamentati.

- Deploy e iterazione rapida: versioni più piccole si addestrano più velocemente, permettono prototipazione veloce, modifiche/domanda-risposta rapide.

- Adatto per domini specifici: quando il contesto è ristretto (formazione tecnica, legale, internal knowledge, customer support), gli SLM spesso bastano.

- Impatto ambientale minore: meno consumi, meno risorse hardware, più sostenibilità.

Contro

- Capacità limitata: su compiti generali, linguaggio vasto, ragionamento complesso, creatività, contesto lungo, gli SLM possono fallire o produrre risposte meno robuste.

- Rischio di overfitting se fine-tuning su dataset piccolo, dominio troppo specifico.

- Bias e generalizzazione: se il training è su dati non sufficientemente rappresentativi, bias più marcati; mancanza di conoscenza “di background”.

- Meno emergenza di abilità non supervisionate: LLM mostrano fenomeni emergenti (tipo chain-of-thought, few-shot) che negli SLM sono più deboli o assenti.

- Manutenzione e aggiornamento: bisogna aggiornare i modelli, che possono rimanere “fermi” se non si dispone di dati aggiornati; rischi di obsolescenza.

Esempi di SLM moderni – Cosa sono Small Language Models

Di seguito qualche esempio attuale di SLM, sia open-source sia proprietari, che rappresentano bene la categoria:

| Modello | Parametri / taglia approssimata | Caratteristiche principali | Uso tipico / punti di forza |

|---|---|---|---|

| Llama 3.2-1B (Meta) | ~1B | versione “leggera” di Llama, ottimizzata per edge, inferenza efficiente. | dispositivi mobili, app con capacità comuni di generazione, assistenti galleggianti in applicazioni consumer. |

| Qwen2-0.5-7B family | varianti da 0.5B fino a ~7B | scalabili; versioni piccole per latenza/memory limit, versioni medie per prestazioni più robuste. | summarization, traduzione, chatbot interni, applicazioni mobile/edge. |

| Phi-3.5-Mini (Microsoft) | ~3.8B o simili nei modelli “mini” o piccoli | ottimizzazione per ragionamento, generazione codice, prestazioni decenti con parametri limitati. | sviluppo software, assistenza tecnica automatizzata, strumenti per developer. |

| Mistral 7B / Mistral Small | ~7B e vari modelli più piccoli recentemente rilasciati da Mistral AI (“Small 3.1”, “Medium”, ecc.) | ottimizzati per efficienza su metriche moderne; alcune versioni con MoE; buon compromesso prestazioni / costo. | applicazioni aziendali, edge server, chatbot interni, automazione di contenuti. |

| Gemma 2 / Gemma 3 (Google DeepMind) | versioni “leggere” / open-source con parametri ridotti, focalizzate su multilingua, prestazioni generali buone. | multilingue, ambienti in cui servono versioni aperte, personalizzazione, uso in ricerca. | |

| TinyLlama | ~1.1B | modello open-source, addestrato su molti token, efficienza computazionale (FlashAttention, ottimizzazioni) | chi lavora con modelli open source, sviluppatori che vogliono portare modelli su device limitati, startup. |

Quando usare gli SLM (scenari e casi d’uso)

Scenari non aziendali / personali / accademici

- App mobili che offrono assistenti vocali / di chat con connettività limitata o con vincolo offline.

- Progetti di ricerca con budget limitato, gruppi università che vogliono esplorare NLP, ragionamento, classificazione.

- Strumenti di accessibilità, tecnologia assistiva (per es. lettura testi, traduzione, trascrizione) da dispositivo locale.

- Hobby, prototipi, applicazioni locali che devono operare con latenza bassa e non dipendere dal cloud.

Scenari aziendali – Cosa sono Small Language Models

- Chatbot interni / assistenza clienti: un SLM ben fine-tuned sul data base aziendale può rispondere a FAQ interne, smistare richieste, generare bozze, senza dover usare costosi LLM via API.

- Elaborazione documentale: classificazione documenti, estrazione di entità, indicizzazione interna; se dominio definito (legale, fiscale, finanziario, sanitario etc.), SLM è spesso sufficiente.

- Edge AI / IoT: dispositivi intelligenti distribuiti che devono rispondere localmente (es. smart speaker, dispositivi medici, sensori dotati di NLP).

- Mobile apps / wearable: app che offrono traduzione reale, suggerimenti personali, funzionalità di writing assistito, tutto locale o con minima connessione.

- Privacy e compliance: nei settori regolamentati (sanità, finanza, difesa), dove dati non possono uscire, un SLM locale controllato può dare soluzioni conformi.

- Risposta di emergenza / fallback: in architetture ibride, LLM usati per compiti generali, SLM per fallback locale, come sistema di continuità se il cloud non è disponibile.

Quando scegliere SLM vs LLM

Usa SLM se:

- il dominio è ben definito e non troppo vasto;

- la latenza, la privacy, il costo sono vincolanti;

- l’hardware è limitato;

- hai bisogno di deploy locali o offline;

- vuoi controllare meglio dati, bias, aggiornamenti.

Meglio usare LLM se:

- necessiti di ragionamenti complessi, capacità emergenti, contesto molto lungo;

- compiti generalisti, zero-shot / few-shot su compiti mai visti;

- qualità / ricchezza del linguaggio è prioritaria, anche a costo di risorse;

- il budget e l’infrastruttura non sono un problema.

Scenari futuri: prospettive concrete – Cosa sono Small Language Models

Ecco alcune tendenze concrete per il futuro degli SLM:

- Ibridi LLM + SLM: architetture miste che usano SLM per la maggior parte dei task comuni, e “ricorrono” a LLM solo quando serve (ragionamento complesso, generazione creativa, contesto molto lungo). Questo aiuta a ridurre costi ed energia complessivi.

- Miglioramenti nelle tecniche di compressione / efficienza: quantizzazione più aggressiva (8 bit, 4 bit), pruning strutturato, sparse attention, architetture efficienti (MoE, architetture distillate) sempre più performanti.

- Contesto lungo e memory efficiente: lavorare su finestre di contesto estese anche nei modelli piccoli, magari tramite memorie esterne, retrieval augmented generation (RAG), caching, composizione modulare.

- Personalizzazione e dominio verticalizzato: SLM specializzati per settori specifici (medicina, diritto, educazione, finanza, logistica), con dataset interni aziendali, modelli custom.

- Edge compute e dispositivi mobili sempre più capaci: con hardware dedicato (NPUs, TPU edge, etc.), acceleratori, modelli ottimizzati che permettono inferenza locale di SLM con prestazioni quasi real-time.

- Standard e tool per valutazione / sicurezza: con l’adozione di SLM, necessari standard per valutare bias, robustezza, privacy, explainability, versioning.

- Formazione e diffusione: man mano che la formazione sui modelli leggeri diventa più accessibile (corsi, tutorial, tool), sempre più sviluppatori, PMI, startup adotteranno soluzioni basate su SLM.

Proposta concreta: “Corsi SLM” – “Formazione SLM” con Innovaformazione

Per sfruttare appieno queste opportunità occorre che i team di sviluppo, AI engineer, ingegneri informatici acquisiscano competenze ben precise: progettare, addestrare, ottimizzare, deployare SLM; saper fare fine-tuning, comprendere quantizzazione/pruning/distillazione, gestione del dominio dati, controllo dei bias, sicurezza.

La scuola Innovaformazione può affiancare le aziende con corsi SLM / formazione SLM strutturati, specializzati per AI Engineer e data scientists, per:

- capire quando un SLM è sufficiente e come dimensionarlo;

- sperimentare modelli quali TinyLlama, Phi-Mini, Gemma, ecc.;

- creare pipeline efficienti di training / inferenza;

- integrare modello su mobile, edge, ambienti on-premises;

- assicurare qualità, sicurezza, governance del modello.

Conclusione – Cosa sono Small Language Models

Gli Small Language Models rappresentano un approccio pragmatico, efficiente e sempre più necessario nel panorama attuale dell’intelligenza artificiale. Pur non avendo la potenza generale degli LLM, offrono vantaggi concreti in termini di costo, latenza, privacy, deployabilità, specialmente per domini ristretti o applicazioni “vicine” agli utenti. Per gli sviluppatori e le aziende, saper valutare quando usare uno SLM, come costruirlo e mantenerlo, può fare la differenza in termini di efficienza operativa, competitività e sostenibilità.

(fonte) (fonte) (fonte) (fonte)

INFO: info@innovaformazione.net – TEL. 3471012275 (Dario Carrassi)

Vuoi essere ricontattato? Lasciaci il tuo numero telefonico e la tua email, ti richiameremo nelle 24h:

Articoli correlati

Cosa è Laminas

Strumenti AI per sistemisti

Integrare l’AI nei propri software

Body Rental SAP

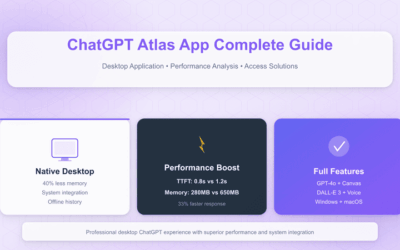

Cosa è ChatGPT Atlas